在工程仿真领域,高保真度的数值模拟是产品性能预测与优化的基石。作为达索系统SIMULIA套件(如Abaqus)的核心用户,工程师们常常面临一个经典的两难困境:为捕捉复杂的物理现象(如应力集中、流场梯度、接触非线性),不得不采用极度精细的网格,但这直接导致计算规模呈指数级增长,耗费海量的CPU时间、内存与存储资源,严重拖慢研发进程,甚至使大规模参数化研究或随机分析变得不切实际。本文将系统性地探讨网格过密问题的根源,并从网格优化技术与替代策略两个维度,提出一套提升计算资源效率的综合解决方案。

一、 问题剖析:网格过密为何成为“资源杀手”

网格过密本质上是“局部过度离散化”。其负面影响远超单纯的计算时长增加:

-

计算成本飙升:有限元/有限体积法的计算量通常与节点或单元数量的n次方(n>1)成正比。网格数量翻倍,单次求解时间可能增加数倍至数十倍。

-

内存与存储瓶颈:精细网格生成庞大的刚度矩阵或系统矩阵,极易耗尽服务器内存,并产生TB级的临时文件与结果数据,对存储I/O构成巨大压力。

-

收敛性与稳定性挑战:过密的网格有时不仅无益,反而可能引入数值噪声,导致非线性问题(如接触、材料塑性)迭代收敛困难,甚至诱发数值不稳定。

-

设计迭代效率低下:在优化循环中,每个设计点的评估时间过长,严重限制了对设计空间的探索广度与深度。

二、 核心优化策略:从“粗放划分”到“智能离散”

解决网格过密问题的首要途径不是盲目减少网格,而是实现网格的智能化、自适应分布。

-

几何清理与理想化:

-

策略:在划分网格前,使用SIMULIA的几何处理工具(如Abaqus/CAE或来自CATIA的关联几何)清除不必要的细微特征(如极小倒角、微孔、装饰性纹路)、填充无关紧要的孔洞、用简化特征替代复杂曲面。

-

收益:消除导致网格被迫加密的几何“陷阱”,为生成均匀、高质量的网格奠定基础。

-

-

结构化与扫掠网格优先:

-

策略:对于具有规则拓扑的几何区域(如拉伸体、旋转体),优先采用结构化网格(六面体/四边形) 或扫掠网格。与自由网格(四面体/三角形)相比,它们在达到同等精度时所需单元数更少,数值扩散低,计算效率更高。

-

工具:充分利用Abaqus中的分区(Partition) 功能,将复杂零件切割为可进行扫掠或映射网格划分的规则区域。

-

-

多级网格密度与梯度控制:

-

策略:应用局部种子布控,仅在关键区域(如应力梯度大、接触界面、流场边界层、裂纹尖端)进行网格加密,在其他非关键区域使用粗网格过渡。严格控制网格尺寸的梯度增长比(通常建议<1.5),避免单元尺寸突变导致精度损失。

-

实施:在Abaqus中,通过定义局部种子密度、使用布种曲线、或基于几何特征(如曲率、邻近度)自动布种来实现。

-

-

高阶单元与减缩积分技术的明智选用:

-

策略:在适当情况下,使用二阶单元(如C3D10, C3D20R)。相比一阶单元,它们能以更少的单元数更准确地描述变形场和应力梯度,但对计算资源要求更高,需权衡。对于大变形、接触问题,可考虑使用减缩积分单元(如C3D8R) 以提高计算效率并缓解剪切自锁,但需注意沙漏控制。

-

注意:并非所有问题都适合高阶单元,需结合具体物理特性判断。

-

-

网格收敛性研究(Mesh Convergence Study):

-

策略:这是避免“无意识”过密网格的黄金法则。通过系统性地加密网格(通常进行2-3次全局或局部加密),监测关键结果(如最大应力、位移、流量系数)的变化。当结果随网格加密的变化低于可接受的工程误差范围(如2%-5%)时,即认为网格已收敛,此前的网格尺寸即为最优平衡点。

-

自动化:可利用Abaqus脚本(Python)自动化执行网格收敛性分析流程。

-

三、 进阶与替代策略:超越传统网格思维

当传统网格优化达到极限时,以下策略可提供突破性进展:

-

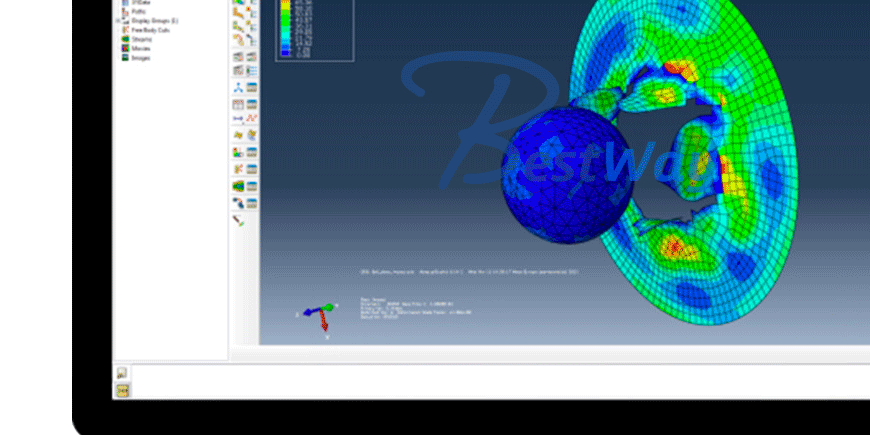

子模型技术(Submodeling/Global-Local Analysis):

-

思路:先用相对粗糙的网格完成整体模型分析,然后在关心的高应力或细节区域切割出子模型,利用整体模型在该区域边界上的位移或力结果作为驱动,对子模型进行高度精细的独立分析。

-

优势:以极小的计算代价,实现关键区域的“显微镜”式高精度分析,完美解决局部网格需求与全局计算成本的矛盾。

-

-

自适应网格重划分(Adaptive Remeshing):

-

思路:在分析过程中(如Abaqus/Explicit中的自适应网格技术),根据用户定义的标准(如单元变形、应变梯度),软件自动在需要区域重新生成更合理的网格。

-

适用:特别适用于大变形问题(如金属成型、橡胶压缩),可防止网格过度畸变导致的分析终止,同时保持关键区域精度。

-

-

无网格法(Meshless Methods)与粒子法的探索:

-

思路:对于极度大变形、断裂、流动伴随材料分离等网格法极度棘手的问题,可考虑SIMULIA中的光滑粒子流体动力学(SPH) 或物质点法(MPM) 等粒子类方法。它们基于粒子离散,天然避免了网格畸变问题。

-

定位:作为对传统FEA的补充,用于处理特定类型的极端非线性问题。

-

-

降阶模型(Reduced Order Models, ROM)与仿真数据挖掘:

-

思路:对于需要在参数空间进行大量快速求解的场景(如优化、稳健性分析),可利用SIMULIA的ROM构建器,基于少量高保真精细网格仿真结果,训练出一个能近乎实时预测系统响应的代理模型。

-

未来方向:这是连接高精度仿真与高效系统级分析、数字孪生的关键技术,能从根本上避免重复调用精细网格模型。

-

四、 实施路线图与最佳实践建议

-

建立标准化网格划分流程:制定企业或项目级的网格划分指南,明确不同分析类型(静力、动力、热、流固耦合)的初始网格尺寸建议、单元类型选择、局部加密原则和收敛性判据。

-

“适合的才是最好的”:牢记仿真目的是为工程决策提供可靠依据,而非追求绝对的数学精确。网格精度应与模型不确定性(材料、载荷、边界条件)和工程公差相匹配。

-

充分运用预处理器的检查工具:在提交计算前,务必使用网格质量检查工具(检查单元形状、长宽比、内角、翘曲度等),确保网格质量达标,避免因劣质网格导致的计算失败或结果失真。

-

拥抱脚本化与自动化:利用Abaqus Python脚本实现参数化建模、网格划分、提交作业和后处理的流程自动化。这不仅保证了一致性,更是高效进行网格敏感性分析和优化的基础。

结论

面对SIMULIA仿真中网格过密带来的资源挑战,工程师应从被动忍受转向主动管理。通过几何简化、智能布种、单元优选等传统网格优化技术,结合子模型、自适应重划分等进阶方法,并积极探索无网格法、降阶模型等新兴替代策略,完全可以在计算精度与效率之间找到最佳平衡点。核心思想是从“均匀密网”的思维定式,转变为“关键区域高保真,非关键区域高效率”的目标导向型离散策略,最终实现仿真驱动研发的效能最大化,让宝贵的计算资源聚焦于真正的工程创新。