摘要: 随着电磁系统复杂度日益增加,大规模仿真对计算资源的需求呈指数级增长。CST Studio Suite作为一款领先的电磁仿真工具,其集成的并行计算功能是突破计算瓶颈、显著缩短项目周期的关键。本文将系统阐述如何有效利用这些功能,从硬件配置到软件设置,全面提升仿真效率。

一、理解CST中的并行计算模式

CST Studio Suite主要支持三种并行计算模式,针对不同仿真类型和硬件环境进行优化:

-

分布式计算(MPI模式)

-

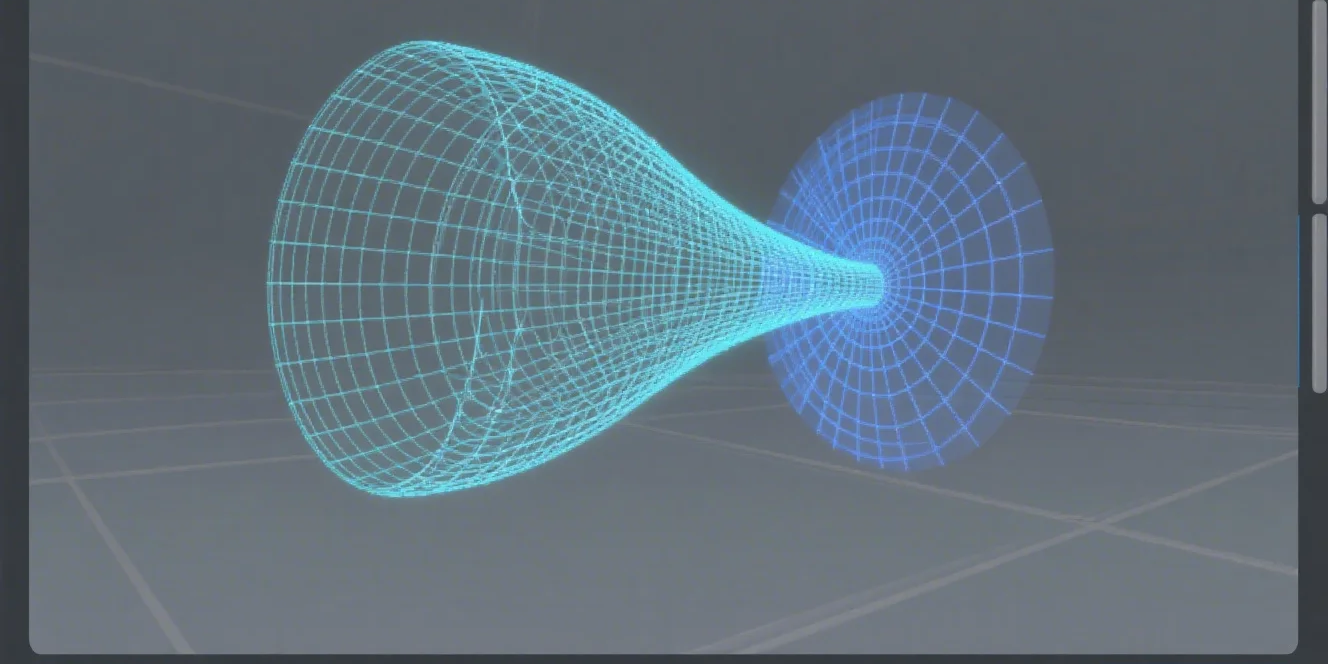

原理: 将仿真域(网格)分割成多个子域,分配给网络互联的多台计算机或单个计算机的多个CPU核心进行并行计算。

-

优势: 非常适合大规模问题,能有效利用集群或工作站的多核资源,突破单机内存限制。

-

适用求解器: 时域求解器、频域求解器(F、I、J)等。

-

-

共享内存计算(OpenMP/多线程模式)

-

原理: 在单个多核计算机上,多个线程共享同一内存空间,并行处理任务(如矩阵运算、频点计算)。

-

优势: 设置简单,通信开销小,适用于参数扫描、优化和频域求解器中的多频点计算。

-

适用求解器: 几乎所有求解器都支持,尤其在天线阵列、参数优化中效果显著。

-

-

GPU加速

-

原理: 利用图形处理器(GPU)成百上千个计算核心进行高度并行化的数值计算。

-

优势: 对特定运算(如时域更新的矩阵运算、矩量法中的矩阵求解)可获得数倍至数十倍的加速比。

-

适用求解器: 时域求解器、积分方程求解器(I-Solver)对GPU支持良好。

-

二、硬件与软件准备

硬件配置建议:

-

CPU: 高核心数处理器。对于MPI模式,核心数越多,并行潜力越大。

-

内存: 充足的内存至关重要。分布式计算中,总内存约为各节点内存之和;共享内存中,所有核心共享同一内存池。

-

网络(用于MPI集群): 高速、低延迟网络(如InfiniBand)能极大减少节点间通信开销,是提升MPI效率的关键。

-

GPU: 选择NVIDIA高性能计算卡(如Tesla、A100系列或消费级RTX系列),并确保显存容量足够存储问题矩阵。

软件要求:

-

确保安装的CST版本支持并行计算模块(通常需要“CST Studio Suite – Performance”或类似许可)。

-

对于MPI集群,需要在所有计算节点上正确安装并配置MPI运行环境(如Intel MPI,已包含在CST安装包中)。

-

安装匹配的GPU驱动和CUDA工具包(如需GPU加速)。

三、软件设置与操作指南

1. 启用并行计算的基本步骤

A. 时域求解器中的设置:

-

在“时域求解器参数”对话框中,找到 “Specials” 或 “加速/性能” 选项卡。

-

选择并行模式:

-

MPI (分布式内存): 指定参与计算的计算机列表(hosts文件)或本地核心数。可手动分配每个核心的网格子域权重,以实现负载均衡。

-

OpenMP (共享内存): 直接设置使用的CPU线程数。

-

GPU加速: 勾选“Use GPU”选项,并选择可用的GPU设备。

-

-

设置完成后,启动求解即可自动启用并行计算。

B. 频域求解器或积分方程求解器中的设置:

-

在相应求解器设置中,通常有明确的 “Parallelization” 或 “分布式计算” 选项卡。

-

可设置并行计算的进程数或线程数,以及是否使用GPU。

-

对于参数扫描或优化任务,可在“任务”设置中启用“并行任务评估”,同时计算多个设计点。

2. 高级策略与最佳实践

-

负载均衡(针对MPI): 对于结构不均匀的模型,CST通常能自动分配网格。但在极端情况下,可手动调整域权重,使各进程计算时间相近,避免“木桶效应”。

-

混合并行模式: 在某些场景下,可结合MPI和OpenMP。例如,在集群的每个节点上使用MPI进行跨节点通信,在每个节点内部使用OpenMP利用多核。这需要更复杂的设置,但可能获得最佳性能。

-

优化GPU使用: 确保仿真问题规模足够大以“喂饱”GPU。小规模问题可能因数据传输开销而无法体现GPU优势。同时监控GPU显存使用情况。

-

并行参数扫描: 当需要进行大量设计变更(如尺寸扫描、优化)时,这是最高效的并行方式之一。每个设计点的仿真可完全独立地分配到不同计算资源上执行。

四、应用实例:大型相控阵天线仿真

以一个256单元的天线阵列仿真为例,展示并行计算策略:

-

单元仿真与阵列分解: 首先,利用参数扫描并行快速仿真和优化单个辐射单元。

-

整体阵列仿真(有限大阵列法): 使用频域求解器的并行功能。

-

设置求解256个激励端口的S参数。

-

启用 “并行端口计算” ,CST会自动将不同端口的计算任务分配到多个CPU核心或GPU上,极大缩短多端口矩阵求解时间。

-

-

全波验证(时域求解器): 对于最终验证或考虑强耦合的场景,进行全阵列仿真。

-

由于网格量巨大(数亿甚至更多),必须采用 MPI分布式计算,将网格分布到集群的数十个节点上。

-

同时,在时域更新循环中启用 GPU加速,进一步加快每个时间步的计算。

-

结果: 原本需要数周的单机串行计算,可缩短至数天甚至数小时内完成。

-

五、注意事项与验证

-

通信开销: MPI并行中,进程间通信会带来额外时间。确保模型规模足够大,使计算收益远大于通信开销。通常,网格量越大,并行效率越高。

-

内存与I/O: 并行计算对磁盘I/O(读写结果文件)也带来压力。使用高性能固态硬盘(NVMe)并设置临时目录到本地高速盘,能避免I/O成为瓶颈。

-

结果验证: 首次使用新并行设置时,务必用小规模模型或简化模型,将并行结果与串行结果进行对比,确保数值精度在可接受范围内。并行计算不应改变仿真结果的物理正确性。

-

资源监控: 使用系统监控工具(如Windows任务管理器、Linux

top)或CST内置的求解器日志,监控CPU/GPU利用率、内存消耗和网络状态,以便发现和解决性能瓶颈。

结论

有效利用CST Studio Suite的并行计算功能,是从根本上加速大规模电磁仿真项目的必由之路。成功的关键在于:

-

精准匹配: 根据仿真类型(时域/频域)、问题规模(网格量)和硬件条件,选择最合适的并行模式(MPI、OpenMP或GPU加速)或它们的组合。

-

精细配置: 从硬件网络、软件环境到求解器参数,进行周密设置和优化,尤其是负载均衡和通信优化。

-

策略性应用: 在项目层面规划并行策略,例如将参数扫描、单元仿真与整体仿真相结合,最大化资源利用率。

通过系统性地应用上述方法,工程师和研究人员能够将以往不可行或耗时过长的大规模电磁仿真任务转化为常规工作,从而在产品设计、研究和开发中获得显著的周期优势与竞争力。